Dringende oproep: leg AI-bedrijven regels op

De ontwikkeling van AI gaat zo snel, dat er dringend internationale afspraken nodig zijn over regels voor AI-software. Dat zegt een groep topwetenschappers en politici.

Zij dringen er bij regeringen op aan om eind 2026 een internationale overeenkomst te hebben gesloten over wat de ‘rode lijnen voor AI’ zijn. Dan moeten deze regels niet alleen operationeel zijn, maar ook voorzien van robuuste mechanismen om ze te handhaven.

Nobelprijswinnaars

De oproep werd gisteren gedaan tijdens de tachtigste sessie van de Algemene Vergadering van de Verenigde Naties (VN). Onder de oproep staan de namen van bekende wetenschappers en politici – waaronder tien Nobelprijswinnaars – en meer dan zeventig organisaties. Daaronder ook het Existential Risk Observatory, een Nederlandse stichting die al jaren waarschuwt tegen de mogelijke gevolgen van uit de hand gelopen kunstmatige intelligentie.

‘Wij zijn bang dat AI relatief snel, binnen bijvoorbeeld drie tot tien jaar, menselijk niveau kan bereiken, en daarna supermenselijk niveau’, reageert Otto Barten van het Existential Risk Observatory op vragen van De Ingenieur.

Medicijnen ontwikkelen

In de tekst gaan de ondertekenaars niet voorbij aan de enorme belofte die AI in zich draagt voor het helpen van de mensheid. Daarvan zijn inmiddels voorbeelden genoeg bekend, van beter hartinfarcten voorspellen tot het versnellen van de ontwikkeling van medicijnen en van het omzeilen van netcongestie tot het helpen van natuurbeschermers.

Desinformatie en beïnvloeding

Maar AI wordt nu zo snel krachtiger dat het in bepaalde dingen binnenkort beter wordt dan de mens. Dat levert risico’s op, zoals gevaarlijke virussen die door de computer zijn ontworpen, grootschalige desinformatie en beïnvloeding van mensen – volwassenen én kinderen (lees ook: ‘Praten met een chatbot kan gevaarlijk zijn’) – , massawerkloosheid en systematische mensenrechtenschendingen.

We hebben te veel laten gebeuren en te weinig gedaan om de risico's [van AI] het hoofd te bieden.

Steeds autonomer en krachtiger

Die gevaren zijn niet alleen maar theoretisch; sommige AI-systemen hebben al schadelijk gedrag vertoond. Tegelijk wordt de software die AI-bedrijven ontwikkelen steeds autonomer en krachtiger. Als we daar niets tegen doen, zeggen de experts die de oproep ondertekenden, zal het steeds moeilijker worden om nog enige zinvolle menselijke controle uit te voeren.

‘Die gevaren van AI moeten gemanaged worden', zegt Otto Barten van het Existential Risk Observatory, ‘waarbij de risico's moeten worden afgewogen tegen de kansen, en waarbij doordachte regulering moet worden ingevoerd. Op dit moment is dat bijna niet het geval.’

‘Te veel laten gebeuren.’

‘Hoewel ik het niet helemaal eens ben met het woord ‘binnenkort’ in het statement, en een andere kijk heb op wat de huidige AI-modellen precies doen, heb ik ook getekend’, schrijft Gary Marcus, emeritus-hoogleraar van New York University en bekend criticaster van de techbedrijven die AI ontwikkelen, in zijn nieuwsbrief. ‘Omdat we te veel hebben laten gebeuren en te weinig hebben gedaan om de risico's [van AI] het hoofd te bieden.’

Internationale overeenkomst nodig

Overheden moeten daarom nu daadkrachtig optreden, voordat de kans voorbij is dat ingrijpen nog zin heeft. Om universeel onaanvaardbare risico’s te voorkomen is dringend een internationale overeenkomst nodig over duidelijke en controleerbare ‘rode lijnen’. Bij het opstellen van deze grenzen zouden alle AI-bedrijven moeten samenwerken. Ook de handhaving moet gezamenlijk worden opgepakt, zodat alle AI-aanbieders verantwoordelijk zijn voor de samen afgesproken drempels.

Voorbeelden

Bij hun oproep maken de opstellers van de tekst onderscheid tussen het gedrag van AI (wat het algoritme kan) en het gebruik van AI (waarvoor het kan worden ingezet). Voorbeelden van rode lijnen in het gedrag van AI zijn:

- Cyberaanvallen; verbied het ongecontroleerd vrijgeven van software die met cyberaanvallen kritieke infrastructuur kan verstoren.

- Massavernietigingswapens; verbied AI-systemen die de ontwikkeling van massavernietigingswapens gemakkelijker maken of die in strijd zijn met de verdragen voor biologische en chemische wapens.

- Zelfreplicatie en zelfverbetering; verbied de ontwikkeling en implementatie van AI-systemen die zichzelf kunnen kopiëren of aanzienlijk verbeteren zonder de uitdrukkelijke toestemming van een mens.

- Uitschakeling; verbied de ontwikkeling van AI-systemen die niet onmiddellijk kunnen worden uitgeschakeld als de menselijke controle erover verloren gaat.

Kernwapens

Ook bij het gebruik van AI geeft de campagne voorbeelden:

- Kernwapens; verbied het delegeren van nucleaire lanceringsbevoegdheden of beslissingen over cruciale commandovoering aan AI-systemen.

- Dodelijke autonome wapens: verbied de inzet en het gebruik van wapensystemen die worden gebruikt om mensen te doden zonder zinvolle menselijke controle en duidelijke plicht tot menselijke verantwoording.

- Massale surveillance: verbied het gebruik van AI-systemen voor systemen met ‘sociale scores’ en massale surveillance.

- Menselijke imitatie: verbied het gebruik en de inzet van AI-systemen die gebruikers laten geloven dat ze met een mens communiceren zonder bekend te maken dat er AI achter zit.

Wie gaat handhaven?

Bij het opstellen van regels en beperkingen hoeven de landen trouwens niet vanaf nul te beginnen. Er bestaan al allerlei afspraken tussen grote groepen landen en tussen grote bedrijven.

De vraag is wel wie de uiteindelijke regels gaat handhaven. Er bestaat geen internationale autoriteit op het gebied van AI. De experts die de oproep doen, stellen voor te streven naar internationale afspraken die door alle landen worden ondertekend. Vervolgens kunnen nationale overheden die afspraken vertalen naar wetgeving voor hun land. Ten slotte zou een internationale organisatie (vergelijkbaar met de International Atomic Energy Agency op het gebied van kernenergie) de taak moeten krijgen om protocollen op te stellen waarmee AI-bedrijven en hun producten kunnen worden doorgelicht.

Het is afwachten wat de landen van de Verenigde Naties gaan doen. Er spelen tegelijkertijd veel meer ingewikkelde kwesties voor de verzamelde landen, zoals de oorlogen in Oekraïne en Gaza. Ook heeft de VN het als organisatie zelf moeilijk, in een tijd waarin innige internationale samenwerking uit de mode lijkt te zijn.

Update 23 september 2025, 16.30 uur: antwoorden van Otto Barten van het Existential Risk Observatory toegevoegd.

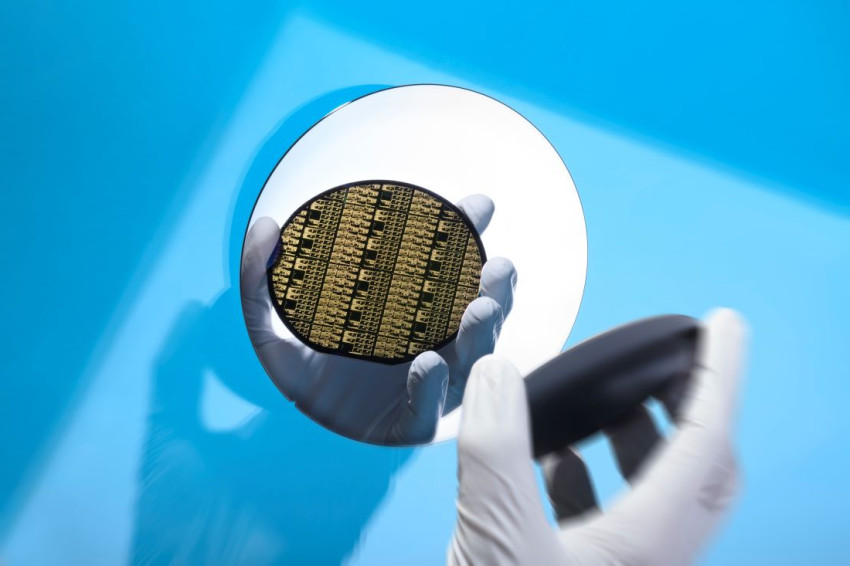

Openingsbeeld: AI-software voor automatische gezichtsherkenning zou aan banden gelegd moeten worden. Foto’s: Depositphotos