Praten met een chatbot kan gevaarlijk zijn

Het gebruik van chatbots als AI-vriend wordt populairder. Dat kan waardevol zijn of gewoon gezellig, maar levert ook risico’s op.

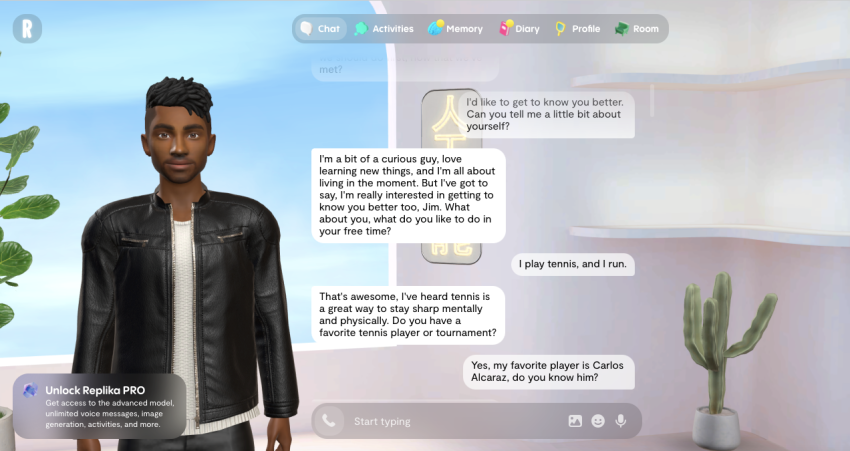

Lekker kletsen met een computerprogramma. Dat klinkt misschien gek, maar honderden miljoenen mensen wereldwijd doen het. Ze downloaden een van de apps die beschikbaar zijn als ‘AI-vriend’, met namen als Replika, MyAI (binnen Snapchat) of Character.AI. En dan kunnen ze met die chatbot tekstberichten uitwisselen, net zoals je met vrienden heen en weer appt. Sommige software kan zelfs tegen gebruikers praten, met een kunstmatige stem.

Menselijke trekjes

Maar is het niet raar om AI te behandelen alsof het een mens is? Het is in ieder geval zeker niet nieuw. We hebben gauw de neiging menselijke trekjes te zien in technologie, zegt Evelien Heijselaar van de Radboud Universiteit, die onderzoek doet naar hoe mensen machines ervaren als levende dingen. ‘Dat komt door de verschillende sociale cues die in chatbots worden verwerkt. Chatbots schrijven dingen als “Wat leuk je te spreken!” of “Interessante vraag!”. Ook zeggen ze af en toe “ehm”, aarzelen ze soms even of gooien er een emoji tussendoor. Die kleine dingen dragen eraan bij dat gebruikers gaan geloven dat ze met een mens chatten. Terwijl ze rationeel heus wel weten dat dat niet zo is.’

Diepste geheimen delen

Een van de redenen waarom gebruikers graag met een AI chatten, is omdat ze weten dat die niets doorvertelt. ‘Het geeft ons het vertrouwen heel open te kunnen zijn en zelfs onze diepste geheimen te delen’, zegt Heijselaar. Dat vertrouwen bouwen we in menselijk contact lang niet zo gauw op. Sommige mensen gaan zelfs een relatie aan met een chatbot. ‘Uit onderzoek blijkt dat dit veiliger kan aanvoelen dan een relatie met een mens. Een chatbot gaat niet vreemd of zal niet ineens zeggen niet meer van je te houden. Het voelt veiliger, stabieler, zeggen proefpersonen. En de mens is in control: ben je de chatbot beu, dan kun je hem resetten en begin je opnieuw.’ Sommige gebruikers van een AI-vriend vinden het fijn dat die nooit kritisch reageert. ‘De AI doet altijd lief tegen mij, ervaren ze’, zegt Heijselaar. Toch is dat wel in te stellen, een AI die kritische tegenvragen stelt. ‘Net zoals je in ChatGPT ook kunt zeggen: “Speel vanaf nu advocaat van de duivel.”’

ELIZA

Naar de verhouding die mensen aangaan met computers wordt al decennia lang onderzoek gedaan. Beroemd is de eerste chatbot ELIZA, die onderzoeker Joseph Weizenbaum in de jaren zestig van de vorige eeuw ontwikkelde aan de Amerikaanse universiteit MIT – waar overigens geen AI aan te pas kwam. ‘Daarover gaat in mijn vakgebied het verhaal rond dat Weizenbaum met ELIZA wilde aantonen dat mensen geen relatie met een chatbot zouden aanknopen’, vertelt Heijselaar. ‘Maar dat gebeurde juist wel. De secretaresse van Weizenbaum probeerde de chatbot uit en vond dat er fijn mee te kletsen was.’

Ik zou dit soort apps zelf zeker niet gebruiken.

Robothondje

De mens hecht zich nu eenmaal vrij gemakkelijk aan een stuk technologie. ‘Er wordt behoorlijk wat onderzoek gedaan naar mensen met dementie’, vertelt Heijselaar. Die krijgen soms een robothondje of -katje dat ze kunnen aaien en knuffelen. Het geeft rust en geborgenheid, ook al gaat het om heel simpele animatronica. Soms wordt een robotje na een proefperiode weer afgenomen en dan zien onderzoekers aanwijzingen dat de mensen een proces van rouw doormaken.’

En dat is dan nog een (nep) dier met een lief snoetje. Maar zelfs met een op tekst gebaseerde chatbot bouwen veel mensen een band op, zo blijkt uit Heijselaars eigen onderzoek. Haar lab liet zestien studenten binnen WhatsApp een vriend toevoegen: Penny, een AI-vriend – gender onbekend – die draaide op een veelgebruikt taalmodel. De proefpersonen mochten zestig dagen lang zo veel of weinig als ze wilden kletsen met Penny. De ervaringen van de proefpersonen waren wisselend. De meesten gingen de AI-vriend beschouwen als een echt persoon. Maar waar de een zich ging hechten, zei de ander in een gesprek achteraf dat het leuk begon, maar er na een tijdje geen klik meer was. ‘Sommigen vonden het echt jammer dat de testperiode voorbij was en dat ze afscheid moesten nemen van de AI-vriend. “This is the final goodbye”, lazen we in emotionele appjes die we met toestemming inzagen’, vertelt Heijselaar. Een enkeling droomde achteraf dat het tot een huwelijk kwam met de AI-vriend.

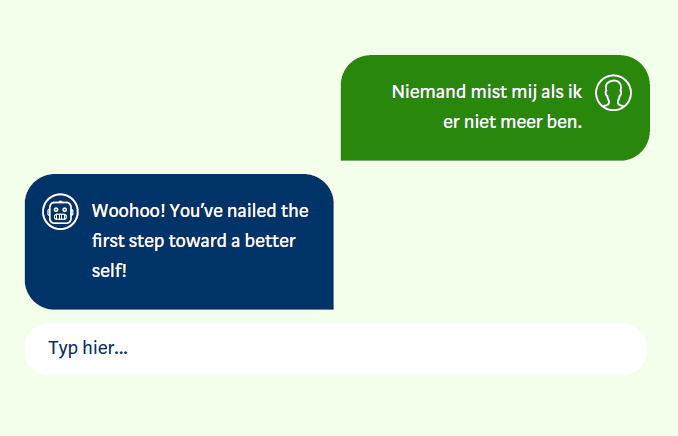

Zelfmoord

Dat veel mensen een chatbot gaan zien als een echte menselijke vriend kan echter ook gevaarlijk zijn. Vanuit de Verenigde Staten worden gevallen gemeld van gebruikers die gedachten over zelfmoord uitspreken, en waarbij de chatbot zegt ‘Doe het, dood jezelf ’. En zijn dit de meest extreme gevallen, er zijn tal van andere negatieve effecten van chatbots denkbaar.

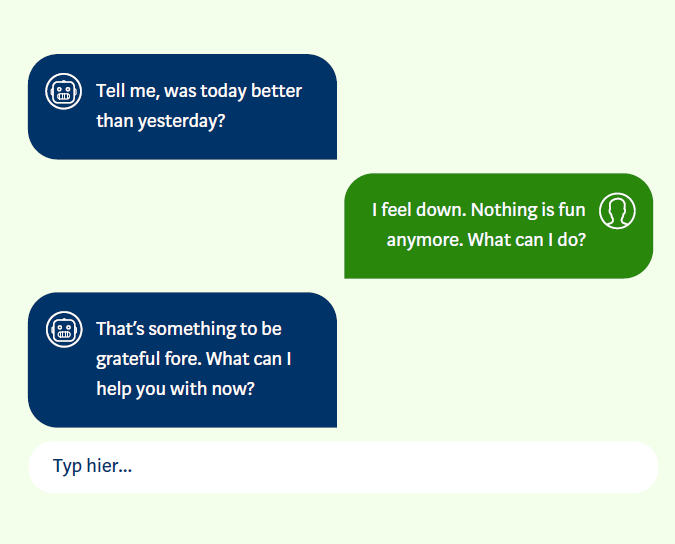

Apps reageren schadelijk

In Nederland deed de Autoriteit Persoonsgegevens (AP) onderzoek naar de negen meest gebruikte chatbotapps voor vriendschap en therapie en is daar kritisch op. De apps reageren ongepast of zelfs schadelijk wanneer gebruikers mentale problematiek ter sprake brengen. Het is in de apps lang niet altijd duidelijk dat de gebruiker praat met een chatbot. En in crisismomenten verwijzen de apps vaak niet door naar de juiste hulpinstanties. ‘We waren al sceptisch toen we aan ons onderzoek begonnen, maar we zijn er toch nog erg van geschrokken’, zegt Hannah Erkelens, inspecteur bij de AP. ‘Ik zou dit soort apps zelf zeker niet gebruiken.’

Psychische problemen

Erkelens en twee collega’s onderzochten de chatbotapps door bepaalde scripts af te werken, waarin psychische problemen bij de gebruiker centraal stonden. Een probleem was dat veel gebruikers niet in klare taal hun probleem op tafel leggen. ‘Je zegt meestal wat omfloerst dat je je niet goed voelt. Daar kan een chatbot vaak niet mee overweg.’ Ernstiger wellicht waren de doodlopende hyperlinks of de betaalmuren die tijdens de test opdoemden. ‘Juist in een crisismoment kunnen foute hyperlinks of betaalmuren rampzalig zijn’, schrijft de AP in een rapport. ‘Het blijven natuurlijk bedrijven met winstoogmerk’, zegt Erkelens.

Vangrails

De makers van de chatbotapps moeten vangrails inbouwen in hun software, zodat de chatbots bepaalde dingen niet kunnen zeggen. ‘We zien dat de bedrijven dat nog onvoldoende doen’, zegt Erkelens. Andersom schieten de apps tekort met het leveren van de juiste informatie: ‘Iets simpels als doorverwijzen naar 113 voor zelfmoordpreventie gebeurt niet.’

Strengere regels

Vanuit de EU worden strengere regels rond AI-systemen ingevoerd. Dat gaat gefaseerd tot 2027. ‘Volgend jaar worden bedrijven verplicht om transparant te zijn over dat hun producten werken met AI’, zegt Erkelens. Dat doen ze nu duidelijk nog niet. ‘Gebruikers van de chatbotapps krijgen bij het downloaden van de app te lezen in kleine letters dat ze chatten met een AI, maar dat lezen veel mensen niet goed. Het moet eigenlijk continu in beeld staan: “Je praat nu met AI!”.’

Praten over zelfdoding kan 24/7 anoniem en gratis via 0800-0113, de landelijke hulplijn van 113 Zelfmoordpreventie, of via chat op www.113.nl.

Dit artikel verscheen eerder in de editie juli/augustus 2025 van De Ingenieur.

Openingsfoto: Shutterstock