Privacyfilter blokkeert gezichtsherkenning

De ene kunstmatige intelligentie fopt de andere. Met dat idee ontwierpen Canadese ingenieurs een filter dat portretfoto’s onherkenbaar maakt voor gezichtsherkenning.

Gezichtsherkenningssoftware is inmiddels zo ver ontwikkeld dat die een foto van je vrijwel foutloos kan identificeren. En elke keer als je een foto of video van jezelf op sociale media zet, leert die gezichtsherkenningssoftware weer een beetje meer van je.

Ingenieurs van de afdeling toegepaste wetenschappen van de Universiteit van Toronto hebben nu een algoritme ontwikkeld dat dient als een privacyfilter. Het algoritme verstoort de gezichtsherkenningssoftware op zo’n manier dat die niet meer werkt.

Strijdende AI

De techniek die de Canadese ingenieurs gebruiken is de zogeheten adversarial training. Daarbij strijden twee kunstmatige intelligentie-algoritmen tegen elkaar. Het ene neurale netwerk is bedoeld om gezichten te herkennen, het andere om dat juist te voorkomen, en die laatste leert voortdurend hoe de eerste gezichten herkent.

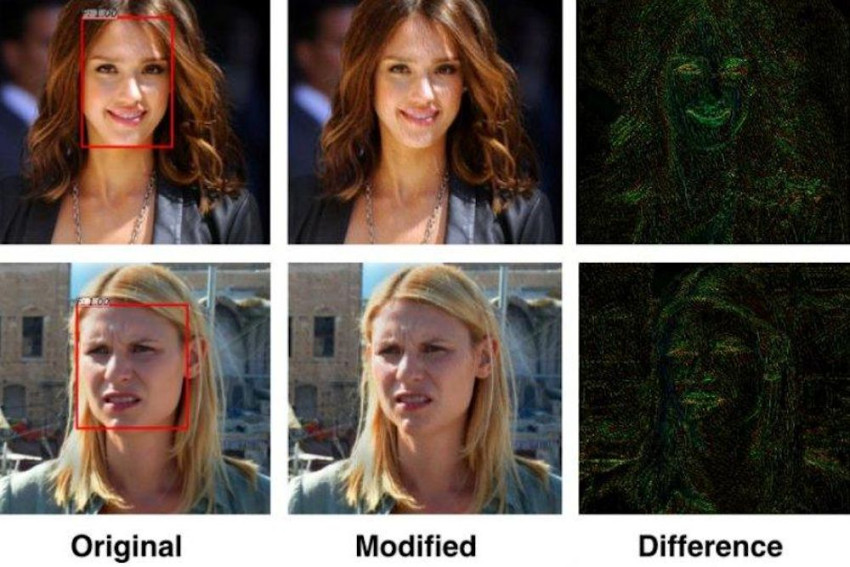

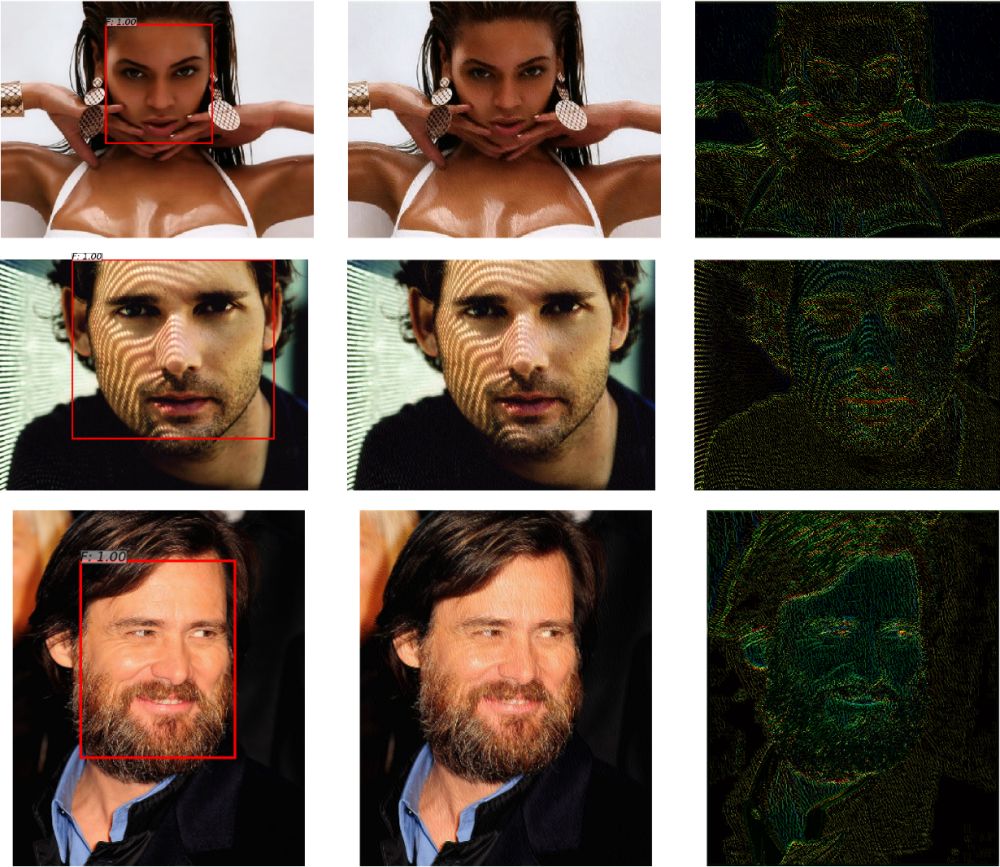

De filterwerking bestaat eruit dat precies die details van de foto worden veranderd die voor de gezichtsherkenningssoftware heel belangrijk zijn. Zo begint die meestal met het herkennen van duidelijke contouren: de omlijning van het gezicht, de plek van de ogen en de mond en dergelijke. Door die met het filter te veranderen, wordt de gezichtsherkenningssoftware voor de gek gehouden. En het mooie is, die veranderingen zijn zo subtiel, dat het menselijk oog ze nauwelijks kan zien. Je foto op Instagram is ook met filter voor je vrienden en vriendinnen nog steeds probleemloos herkenbaar.

Herkenning van 100 naar 0,5 procent

De ingenieurs pasten hun techniek toe op de 300-W gezichtendataset, een standaard database met meer dan 600 foto’s van allerhande gezichten. De score van de gezichtsherkenningsoftware ging met het filter omlaag van 100 % naar 0,5 %.

Behalve gezichtsherkenning verstoort het filter ook zoekopdrachten op basis van een portretfoto, inschatting van emotie en etniciteit en andere op gezichtsherkenning gebaseerde algoritmen, zoals de omstreden herkenning van seksuele geaardheid (lees 'Algoritme herkent homo aan gezicht')

Het team is van plan het privacyfilter publiek beschikbaar te stellen.

Niet duidelijk is of de door de onderzoekers genoemde tweestrijd tussen de herkennings- en verstoringssoftware ertoe zal leiden dat de herkenningssoftware zichzelf gaat verbeteren. Ook is niet duidelijk hoe effectief het privacyfilter is voor de gezichtsherkenningssoftware van Facebook of Amazon, waarvan de algoritmen niet bekend zijn.

Beeld:Gezichten uit de 300-W database, links niet verstoord, midden met filter en rechts het verschil, dat 10x is versterkt om goed zichtbaar te maken. Bron: University of Toronto.