Computer praat eindelijk als mens

Dankzij een speciaal algoritme van Google kunnen computers binnenkort net zo naturel praten als mensen. Daarmee is de aloude onnatuurlijke computerstem eindelijk verleden tijd.

Iedereen heeft er wel een keer mee lopen stoeien: de tekst-naar-spraak-machine van Windows. Het heeft iets magisch: een paar regels tekst tikken die de computer vervolgens met een druk op de knop uitspreekt. Of denk aan de stemcomputer van de wereldberoemde astrofysicus Stephen Hawking. Hij doet wat hij moet doen, maar het is geen menselijke stem. Hij klinkt houterig, de stem hakkelt van zinsdeel naar zinsdeel zonder enig metrum en weet over het algemeen niet te overtuigen. Zelfs moderne computerstemmen, zoals de digitale assistent Siri in Apple-producten, heeft hier last van. Niemand zal de stemmen van dergelijke programma's met een menselijke stem verwarren.

De band Radiohead maakte op het album OK Computer (1997) gebruik van de stemcomputer van de Apple Macintosh.

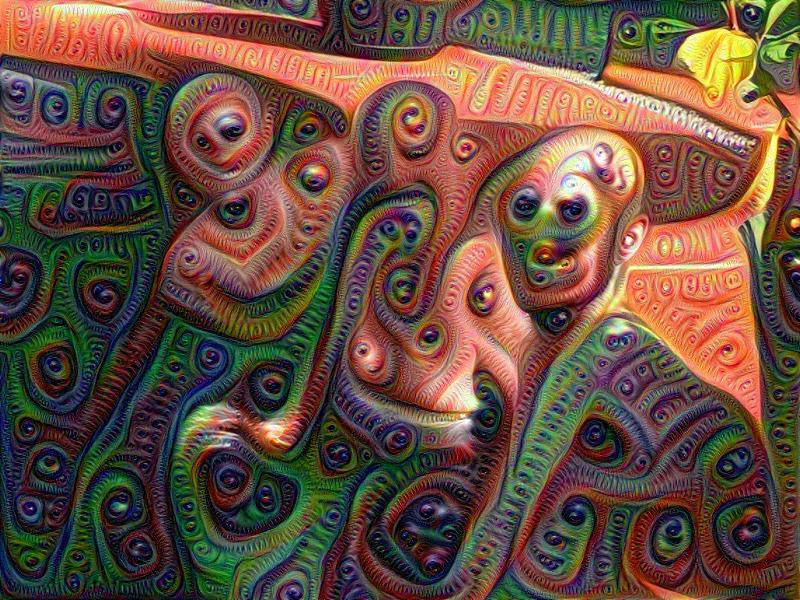

Vreemde beelden

Daar wil Google verandering in brengen. Dat gaf het eigen bedrijf Deepmind de opdracht om een perfecte tekst-naar-spraak-omzetter te maken. Deepmind heeft al een aantal bijzondere projecten rond kunstmatige intelligentie voltooid. AlphaGo, de AI die professionele spelers van het bordspel Go versloeg (artikel 'Computer verslaat de mens met 4-1 bij GO'), kwam uit hun keuken, evenals DeepDream, het verontrustende maar fascinerende beeldherkenningsalgoritme dat overal dromerige patronen in zag (artikel 'Google maakt hondenpizza').

Nu denkt Deepmind ook de wereld van computerspraak te kunnen veranderen. Daarvoor bouwden ze WaveNet, een algoritme dat via een neuraal netwerk leert praten. De input (gesproken tekst) gaat door een aantal verborgen lagen (DeepMind geeft niet bloot wat er precies gebeurt in die lagen) waarin de informatie gecombineerd wordt, totdat het uiteindelijk leidt tot een les: het algoritme weet dan hoe het een bepaald woord of bepaalde zin uit moet spreken.

25 uur Engels

Daarvoor is veel training nodig. DeepMind gebruikte tekstdatabases met bijna 25 uur onafgebroken Engelstalige tekst. Het algoritme deed zijn ding en het resultaat is indrukwekkend. Het klinkt inderdaad alsof een mens de zinnen uitspreekt in plaats van een computer. Vergelijk maar de 'klassieke' spraakcomputer met Wavenet. (Onderaan de blogpost van DeepMind zijn nog meer voorbeelden te vinden)

De grootste kracht van het algoritme is de flexibiliteit. De onderzoekers voerden ook 35 uur Mandarijn (Chinees) door het algoritme en ook daaruit volgde een stemcomputer die goed Mandarijn spreekt. Volgens Google zijn zowel Engels als Mandarijn de beste tekst-naar-stem-resultaten ooit.

Muziek

Nog opmerkelijker is het feit dat het algoritme ook met andere inputs werkt. Bij wijze van experiment lieten de onderzoekers urenlang pianomuziek van Chopin horen. Het resultaat? Een computerprogramma dat uit zichzelf pianomelodieën produceert. Het is misschien nog niet op het niveau van een meestercomponist, maar laat wel zien waar neurale netwerken toe in staat zijn.

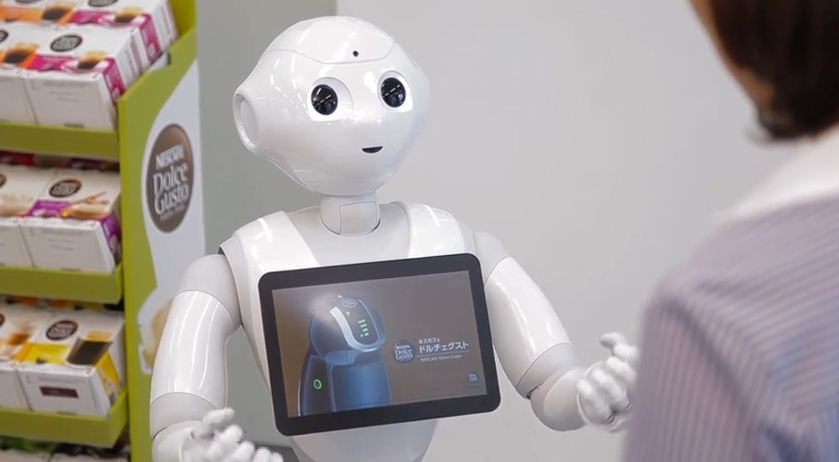

Openingsbeeld: Nestlé