Nepnieuws bestrijd je niet met algoritmen

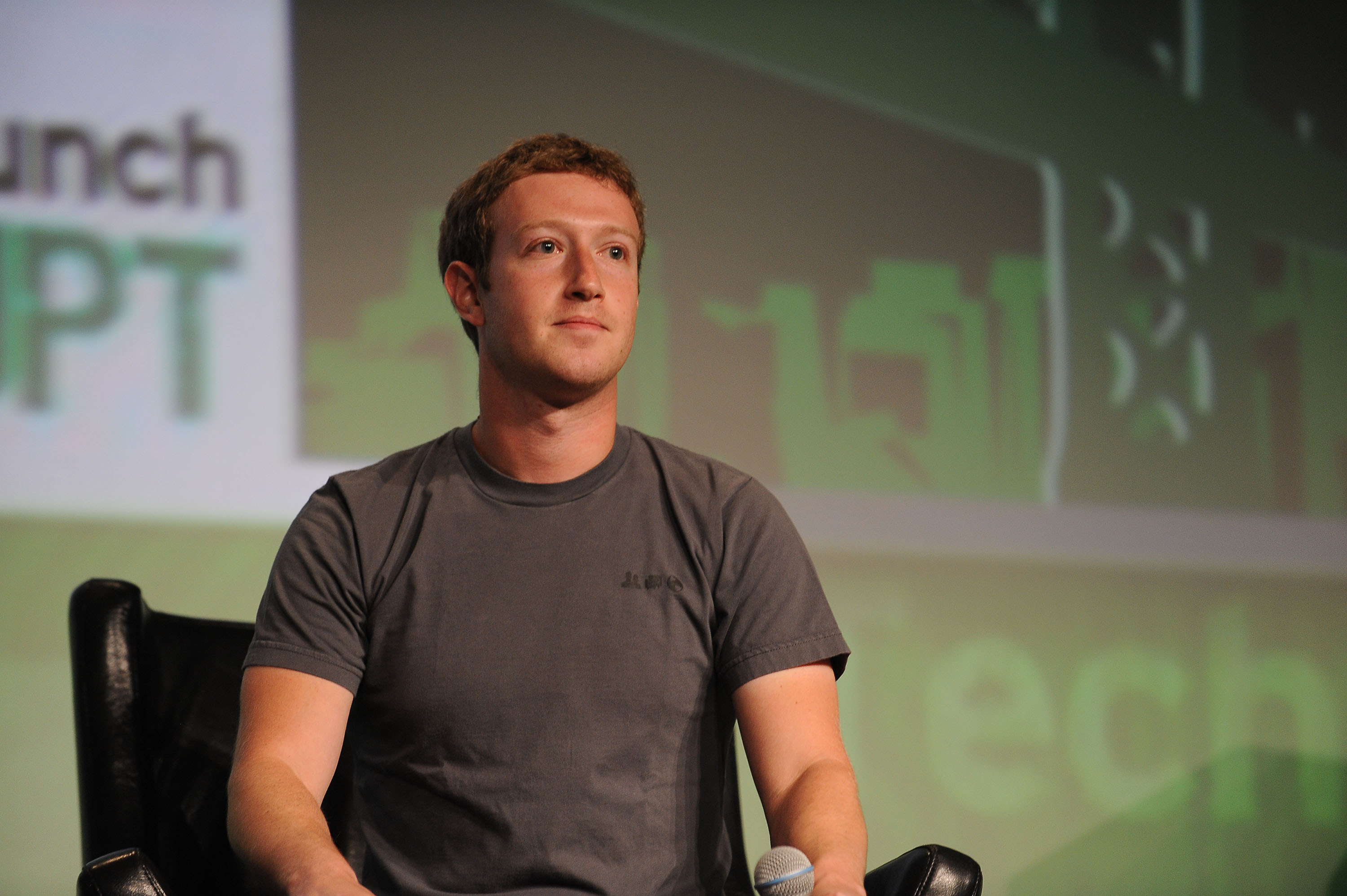

Facebook-CEO Mark Zuckerberg zit in de problemen. Zijn waanzinnig succesvolle sociale netwerk (vier miljard gebruikers wereldwijd) heeft een geloofwaardigheidsprobleem. Dat wil zeggen: een groot deel van de populairste berichten bestaat uit nepnieuws.

Vlak na de Amerikaanse verkiezingen, die verrassend werden gewonnen door Donald Trump, ging men op zoek naar de oorzaak van deze verbazingwekkende uitslag. Al snel wezen verschillende kranten en websites naar Facebook. Het algoritme van de website dat berichten aanbeveelt laat gebruikers alleen dingen zien die ze leuk vinden, waardoor conservatieve kiezers nooit zagen dat Trump constant liegt, vrouwonvriendelijk is en racistische uitspraken doet. Wel zagen ze dat Hillary het gevang in moest, beroemdheden (inclusief de paus) massaal hun steun voor de New Yorkse zakenman uitspraken en dat de huidige first lady een 'perverseling' zou zijn.

Geen van die berichten was waar. Toch heeft de bron van die berichten – een website met de naam American News – 700.000 likes meer dan kwaliteitsmedium The Washington Post, dat de afgelopen verkiezingen vrijwel alles netjes factcheckte en schreef wat er klopte en wat niet. Dat deed de krant bij beide kandidaten, niet alleen bij Trump.

Populariteit als maatstaf voor zichtbaarheid bleek een groot probleem voor waarheidsvinding. Mensen die niet kritisch lezen begonnen zo te geloven dat nepnieuws/propaganda de enige echte waarheid was. Dat de onderwerpen op de Facebookfeed nooit aan bod kwamen op televisie, radio of op respectabeler websites voedde alleen maar hun idee dat de échte waarheid niet meer door de mainstream media gebracht werd.

Beterschap

Mark Zuckerberg ontkende aanvankelijk elke invloed van Facebook. 'Mensen van links én rechts zien hun eigen nepnieuws, dus de invloed op verkiezingen is neutraal' was zijn verdediging. De kritiek bleef echter en inmiddels heeft de CEO beterschap beloofd.

De belangrijkste punten: Facebook gaat het detectie-algoritme voor nepnieuws verbeteren, gebruikers kunnen straks makkelijker nieuws aangeven als 'nep' en de 'gerelateerd nieuws'-balk zal voortaan geen nepnieuws meer bevatten.

Het controleren van een bron, analyseren van een persbericht of speech, het factchecken van een claim – allemaal dingen die journalisten al jaren doen en waar ze goed in zijn.

Dat lijken goede stappen, maar het is twijfelachtig of de algoritmen die populariteit vóór waarheid plaatsen, het probleem kunnen oplossen, zelfs na aanpassing. De geschiedenis van Facebook leert ons bovendien dat het bedrijf consistent de eenvoudigste en doeltreffendste oplossing van allemaal weigert: de mens. Zoals de Columbia Journalism Review (een vakblad voor Amerikaanse journalisten) al uiteenzet zijn mensen, en in het bijzonder getrainde journalisten, heel goed in het herkennen van nepnieuws. Het controleren van een bron, analyseren van een persbericht of speech, het factchecken van een claim – allemaal dingen die journalisten al jaren doen en waar ze goed in zijn.

Partijdig

Toch weigert Zuckerberg journalisten aan te nemen. Waarschijnlijk heeft hij de vorige Facebook-controverse nog vers in het geheugen liggen. Facebook had een klein team van onderbetaalde journalisten in dienst om de trending news items te controleren. Zo zouden alleen relevante onderwerpen in de balk komen. Ondertussen werkten de journalisten aan hun eigen ontslag: hun hoofddoel was het trainen van een algoritme dat uiteindelijk zelf de selectie tussen 'slecht' nieuws (nep, irrelevant, etc) en 'goed' nieuws te maken. Gizmodo onthulde echter dat deze redacteuren regelmatig populaire conservatieve nieuwsberichten uit de trending-balk verwijderden. Daarmee dreigde een zweem van partijdigheid voor de populaire website, dus de redacteuren moesten weg. Ingenieurs zouden het voortaan overnemen. Met hun slimme programmeerkennis zouden zij een computer binnen no-time tot een goede journalist maken.

Inmiddels zal Facebook zich op het hoofd krabben over die keus om journalisten te ontslaan. Onduidelijk is nog steeds wat de aard van die verwijderde populaire berichten was. Maar als de analyse van The Daily Beast over trending nieuws op Facebook een indicatie is, is er een grote kans dat het nepnieuws betrof – dat dus volledig terecht weggehaald werd. Facebook blijkt zich inderdaad op de vlakte te houden uit angst voor een conservatieve tegenreactie als ze nepnieuws zouden verwijderen.

Robotisering

Hier botst de vooruitgang van techniek, de 'robotisering' van traditioneel mensenwerk, met de kwaliteit van het geleverde werk. Het is duidelijk dat algoritmen nog niet klaar zijn voor serieuze journalistiek, maar Facebook maakte toch de overstap naar algoritmen. Het verloop van de verkiezingen laten zien hoe gevaarlijk dat is. Want het 'nepnieuws' is feitelijk niets anders dan propaganda, onwaarheid die in zulke grote hoeveelheden op een lezer afkomt dat hij het gaat geloven. Normale journalistiek is een tegengif voor propaganda, maar zolang techbedrijven de mens als obstakel in plaats van waardevolle toevoeging zien zullen dergelijke fouten gemaakt worden.

Misschien moet Facebook weer eens mensen vragen om baggernieuws te filteren

Het probleem is dat mensen feilbaar, standplaatsgebonden en soms partijdig zijn. Dat geldt ook voor journalisten. Een goede journalist zorgt echter dat zijn werkt uit feiten bestaat, niet uit suggesties of duidelijke onwaarheden. Bovendien zijn de algoritmen net zo zeer door mensen met vooringenomenheid geschreven, waardoor er onzichtbare aannames inzitten die beinvloeden hoe een programma werkt. Omdat die algoritmische vooringenomenheid echter minder zichtbaar is, kan een techbedrijf eerder neutraliteit veinzen en aansprakelijkheid wegwuiven.

Die illusie van objectiviteit en politieke neutraliteit is voor een sociaal medium van essentieel belang. Een bedrijf als Facebook wil niet de helft van zijn gebruikers kwijtraken. Neutraliteit klinkt aimabel, maar als je daarmee de grootste verspreider van extreem-rechtse propaganda wordt mag je je afvragen hoeveel deze schijnneutraliteit je waard is. En of je misschien toch weer eens mensen moet vragen om je baggernieuws te filteren tot iets dat respectabel, of, op zijn minst, waar is.

Openingsbeeld: Charis Tsevis