Nobelprijs natuurkunde voor grondleggers kunstmatige intelligentie

De Nobelprijs voor natuurkunde gaat dit jaar naar John Hopfield en Geoffrey Hinton, voor hun baanbrekende werk aan neurale netwerken. Dat werd vandaag bekendgemaakt.

Op het eerste gezicht lijkt het misschien een wat onverwachte keuze van het Nobel-comité, om de natuurkundeprijs toe te kennen voor een onderwerp dat meer thuishoort in de informatica – computer science.

Maar deze twee natuurkundigen hebben álles met kunstmatige intelligentie te maken. Het gaat hier namelijk om de natuurkunde waaruit het concept van neurale netwerken voortkwam – het principe waarop ook de werking van het brein is gebaseerd. De twee gelauwerde natuurkundigen werkten hier al decennia geleden aan.

Patronen opslaan

De Amerikaan Hopfield (geboren 1933) vond een netwerk uit dat een speciale methode gebruikt om patronen op te slaan en weer terug te halen, schrijft de Koninklijke Zweedse Academie van Wetenschappen in een persbericht op zijn site.

Dit naar hem genoemde Hopfield-netwerk maakt gebruik van concepten uit de natuurkunde, zoals de spins van atomen in een magnetisch materiaal. Die beïnvloeden elkaar onderling, in een systeem dat als geheel streeft naar de laagst mogelijke energie.

Pixels

De knooppunten in een Hopfield-netwerk kun je zien als pixels. Zou je aan het Hopfield-netwerk een vervormd of onvolledig beeld geven, en het vragen het opgeslagen beeld te vinden dat hiervan de basis vormt, dan gaat het netwerk systematisch alle knooppunten langs werkt hun waarden bij zodanig dat de energie van het netwerk daalt. Het netwerk probeert zo stapsgewijs om de opgeslagen afbeelding te vinden die het meest lijkt op de onvolmaakte afbeelding die het aanvankelijk te verwerken kreeg.

Elementen herkennen in data

Met het werk van Geoffrey Hinton (1947) kwam vervolgens het vakgebied van de kunstmatige intelligentie in zicht. De Engelsman bouwde namelijk voort op Hopfields werk door een nieuw type netwerk te bedenken: de Boltzmann-‘machine’. Dit is een netwerk dat zelf bepaalde karakteristieke elementen kan herkennen in een grote hoeveelheid data, aldus het persbericht.

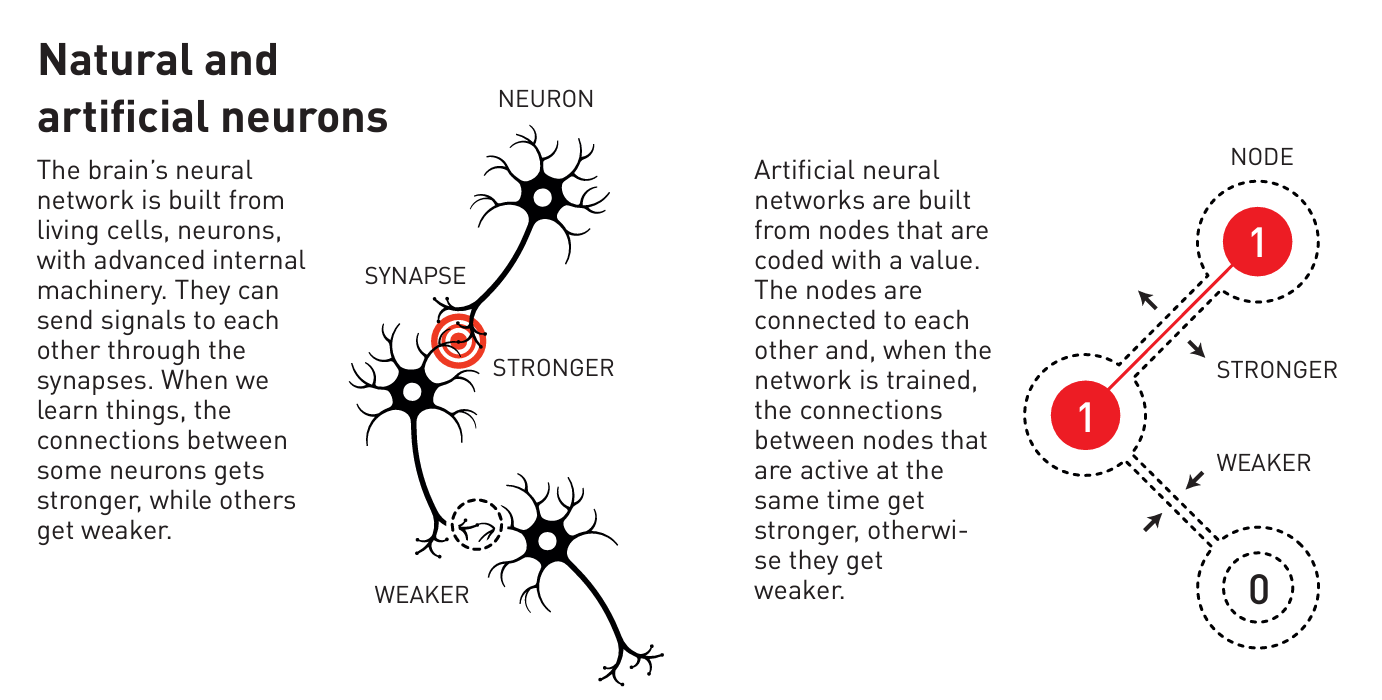

Geïnspireerd op het brein

De Boltzmann-machine is een voorbeeld van een kunstmatig neuraal netwerk, dat is geïnspireerd op hoe een écht neuraal netwerk, namelijk het brein, werkt (zie de afbeelding hierboven). Dat is een complex netwerk van neuronen die met lange vertakkingen met elkaar in contact staan. Wanneer iemand zijn brein gebruikt, om iets te leren bijvoorbeeld, worden de verbindingen tussen verschillende neuronen sterker, en andere zwakker. Het principe van deze verbindingen is nagemaakt in neurale netwerken, waarvan tegenwoordig vele lagen op elkaar worden gebruikt; ze worden dan diepe neurale netwerken genoemd.

Patroonherkenning

Deze eerste ruwe vorm van spontane patroonherkenning – die al wat doet denken aan de hedendaagse AI – kreeg Hinton voor elkaar door wiskunde te gebruiken uit de statistische fysica. Deze tak van de natuurkunde beschrijft systemen van ontelbare identieke deeltjes, zoals de moleculen in een gas (Daaruit volgen eigenschappen als druk en temperatuur, die voor losse moleculen geen betekenis hebben.)

De Boltzmann-machine van Hinton was te trainen door voorbeelden erin te stoppen die het meest waarschijnlijk eruit zouden komen als de ‘machine’ wordt gebruikt. De Boltzmann-machine kon al worden gebruikt om plaatjes te classificeren (tegenwoordig kunnen dergelijke algoritmen katten of honden aanwijzen op nieuwe beelden), maar ook om nieuwe voorbeelden te bedenken van het patroon waarop hij was getraind.

Lagen met knooppunten

In de jaren negentig verloren veel wetenschappers hun interesse in kunstmatige neurale netwerken, maar Hinton ging er stug mee door, samen met enkele anderen. In 2006 kwam daaruit een heel nieuw idee voort: het combineren van meerdere Boltzmann-machines door ze op elkaar te leggen. Dit gaf het netwerk een beter uitgangspunt voor het herkennen van onderdelen van plaatjes. Tegenwoordig bestaan neurale netwerken uit vele lagen met knooppunten bovenop elkaar; vele tientallen tot soms honderden lagen.

ChatGPT

Dankzij de toegenomen rekenkracht van computers kwam het vakgebied (en de industrietak) van kunstmatige intelligentie en, daarbinnen, machine learning rond 2010 pas echt van de grond. Het feit dat in 2022 ChatGPT gelanceerd kon worden, en AI nu wordt gezien als meest revolutionaire technologie (Lees ook: ‘Deze studenten pionieren met AI’ en ‘Wat heeft generatieve AI de ingenieur te bieden?’), is voor een deel te danken aan beide wetenschappers die vandaag zijn geëerd met de Nobelprijs voor de natuurkunde.

Taalmodellen

In 1982 probeerde Hopfield een netwerk met honderd knooppunten door te rekenen, maar daar waren zijn computers niet toe in staat. Vergelijk dat eens met de enorme taalmodellen (large language models, LLM’s) van vandaag de dag, die achter ChatGPT en vergelijkbare chatbots zitten. Die bevatten inmiddels al gauw een biljoen (een miljoen keer een miljoen) parameters.

Dat het trainen en gebruiken van deze enorme taalmodellen steeds meer energie kost, is weer een ander verhaal. De nuttige toepassingen lijken in ieder geval eindeloos. Razendsnelle chatbots kunnen je teksten samenvatten, je mailtjes beantwoorden of artikelen vertalen.

Higgsdeeltje

En de cirkel is ook mooi rond, want natuurkundigen maken dankbaar – en trouwens al veel langer – gebruik van machine learning. Dat heeft zelfs al tot eerdere Nobelprijzen geleid, merkt het Nobel-comité op. Voor het ontdekken van het Higgsdeeltje waren zulke belachelijke hoeveelheden data nodig om uit te pluizen, dat dit zonder machine learning nooit was gelukt. Ook bij onderzoek naar gravitatiegolven kunnen wetenschappers niet meer zonder deze AI-technieken om de ruis uit binnenkomende signalen te filteren.

Openingsbeeld: de twee winnaars van de Nobelprijs voor natuurkunde 2024, John Hopfield en Geoffrey Hinton. Illustratie Niklas Elmehed © Nobel Prize Outreach