Maker nep-video in de verdediging

Een vooraanstaande wetenschapper op het gebied van videomanipulatie heeft zijn werk in een lezing verdedigd. Zijn punt: de technologie voor het maken van nepvideo’s kan ook dienen om fake videos te herkennen.

Vorig jaar veroorzaakte een nepvideo van een speech van voormalig president Obama opschudding, omdat een algoritme bij een bestaand audiofragment de passende mondbewegingen had berekend. Daardoor ontstond een nieuw videofragment met nep-beelden die toch zeer geloofwaardig overkwamen (lees: ‘Video met ingesproken speech lijkt levensecht’).

Veel mensen waren geschokt omdat dit onderzoek suggereerde dat straks bij allerlei geluidsopnamen betrouwbaar ogende videobeelden van sprekende mensen te produceren zijn. In een tijdperk waar fake news aan de orde van de dag is, is dit een donker vooruitzicht.

Helpen

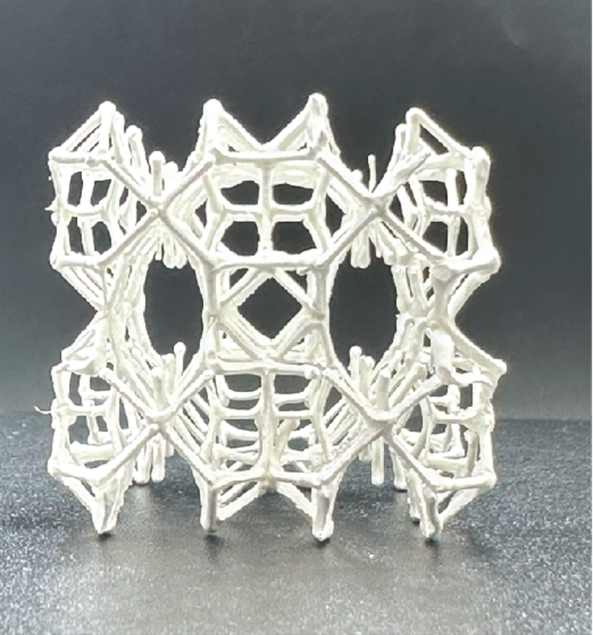

Een van de makers van de videotechniek is Supasorn Suwajanakorn (foto rechts), destijds werkzaam aan de Amerikaanse University of Washington. Hij gaf onlangs in een TED-presentatie toe dat hiermee misbruik mogelijk is, meldt de BBC. Maar zijn technologie kan ook helpen met het opsporen van nepvideo’s en nepfoto’s, zei Suwajanakorn in de TED-talk in Vancouver, begin maart.

Een van de makers van de videotechniek is Supasorn Suwajanakorn (foto rechts), destijds werkzaam aan de Amerikaanse University of Washington. Hij gaf onlangs in een TED-presentatie toe dat hiermee misbruik mogelijk is, meldt de BBC. Maar zijn technologie kan ook helpen met het opsporen van nepvideo’s en nepfoto’s, zei Suwajanakorn in de TED-talk in Vancouver, begin maart.

Nepvideo’s kunnen een hoop schade aanrichten. Een recent voorbeeld hebben we gezien met zogeheten deepfakes, video’s gemaakt met een eenvoudig stukje software waarmee je foto’s van gezichten naar keuze over naaktvideo’s kunt plakken. Op die manier lijkt het alsof iemand met een naaktvideo op internet staat, terwijl dat helemaal niet het geval is.

Bedreigd

Buitengewoon vervelend is dat, maar de gevolgen kunnen nog heftiger worden als nepfoto’s politieke doelen gaan dienen. In Nederland hebben we dat bijvoorbeeld gezien met een gefabriceerde foto met D66-fractievoorzitter Alexander Pechtold in een demonstratie van fundamentalistische moslims, die door PVV-voorman Geert Wilders werd getwitterd. Pechtold werd na het verspreiden van die nepfoto zelfs bedreigd.

Nepvideo's zijn nieuw

Waar gephotoshopte foto’s al langer bestaan, zijn gefabriceerde video’s een relatief nieuw verschijnsel. Toch zijn nepvideo’s vooralsnog vaak gemakkelijk te detecteren, zegt Suwajanakorn, doordat het lastig is om echt alle frames levensecht op elkaar te laten aansluiten.

Zo had de software bij de Obama-video nog de neiging om een dubbele kin te produceren wanneer de kin in het beeld samenvalt met de bovenste rand van het overhemd. ‘Ook tanden en de tong zijn lastig om te modelleren. Dat zou nog wel tien jaar kunnen duren’, aldus de onderzoeker, die inmiddels bij Google werkt.

Reverse-engineeren

Bij zijn relativering van de nieuwe technologieën voor videomanipulatie krijgt Suwajanakorn in een video van de BBC steun van zijn voormalige collega, universitair docent Ira Kemelmacher-Shlizerman van de University of Washington. ‘Bijna alle technologieën kun je ten goede en ten kwade gebruiken. Zo ook hier. Maar het mooie is dat we, nu we weten hoe we video’s kunnen produceren bij audio, dat proces ook kunnen reverse-engineeren. Daarmee kunnen we dus een methode ontwikkelen om video’s te herkennen die gefabriceerd zijn.’

Wapenwedloop

De eerste vraag die dit oproept, is hoe dit ooit praktisch uitvoerbaar moet worden. Komt er een instantie die alle video's gaat testen en van een keurmerk 'echt' voorzien? Dat lijkt onbegonnen werk.

En ten tweede lijkt het wel mooi en nobel, maar wat Kemelmacher-Shlizerman schetst zou kunnen leiden tot een soort wapenwedloop tussen videomanipulatoren en de controleurs. Het land of het grote bedrijf dat het meeste geld kan pompen in het ontwikkelen van kunstmatige intelligentie en videomanipulatie kan op termijn misschien de perfecte nepvideo produceren, die werkelijk niet van echt te onderscheiden is. Een doodenge situatie, want dan is de publieke opinie te beïnvloeden met ogenschijnlijk authentieke video’s. Net zoals nu nep-nieuwsberichten de stemming onder groepen mensen kunnen doen kantelen. Wordt ongetwijfeld vervolgd.

Beeldmateriaal Supasorn Suwajanakorn