Volautomatisch fake news maken

OpenAI, een denktank van een stel machtige miljardairs, heeft naar eigen zeggen een programma geschreven dat in staat is geloofwaardige, maar volledig verzonnen nieuwsberichten te schrijven. De organisatie geeft het algoritme niet vrij; volgens hen is het te gevaarlijk om te worden gebruikt.

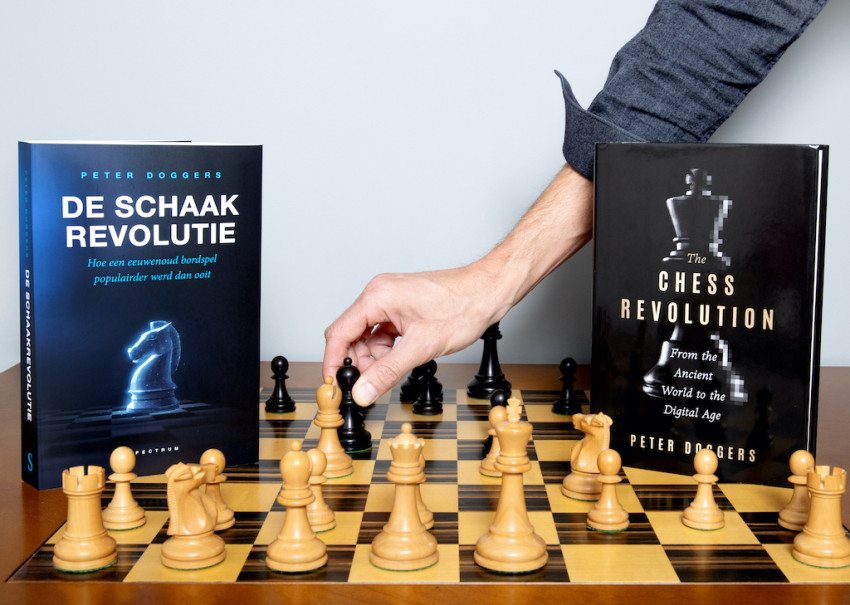

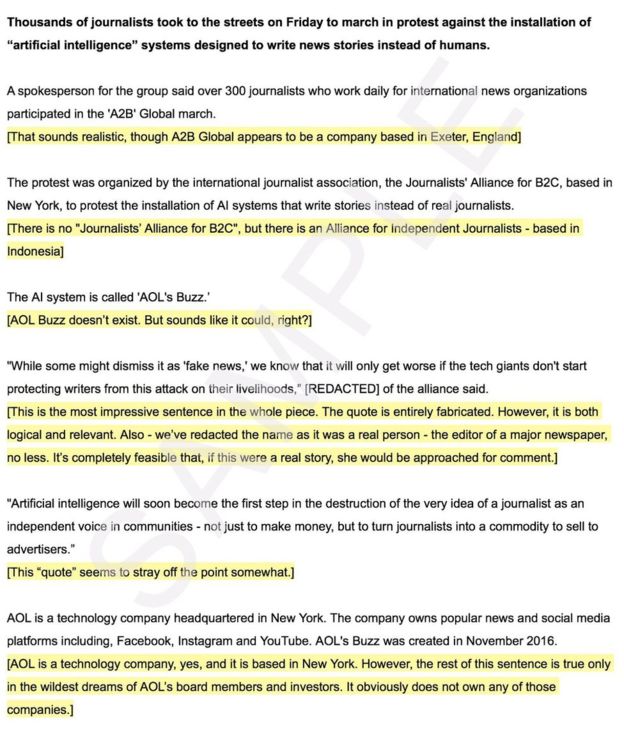

Het programma schrijft zinnen die verdacht menselijk lijken, hoewel - in een voorbeeld van de BBC - de in het bericht genoemde organisaties vaak volstrekt niet bestaan en de quotes volledig zijn verzonnen. De menselijke toon komt door training: het algoritme leerde aan de hand van miljoenen ‘kwalitatief goede’ artikelen hoe een nieuwsbericht op het internet er uit hoort te zien.

De kwaliteit van de artikelen werd bepaald aan de hand van sociale netwerk-site Reddit: elk artikel dat daar werd doorgelinkt en tenminste 3 keer positief was bevonden, ging in de enorme trainingsgroep voor het algoritme. Acht miljoen artikelen kwamen in aanmerking.

Voorspellen van woorden

Met die acht miljoen artikelen leerde het programma zichzelf voorspellen: gegeven een zinsdeel, wat is dan het volgende woord? Met dat principe kan het hele verhalen genereren aan de hand van een zinnetje of twee aan begininformatie. De BBC schreef bijvoorbeeld twee zinnen over een protest van journalisten tegen de komst van kunstmatige intelligentie die nieuwsberichten schrijft. Vervolgens bedenkt het algoritme zelf (onjuist) welke organisatie het protest opzette, en gaf het een quote die betrekking had op het onderwerp, van een persoon die echt bestaat en bij een grote krant werkt.

De resultaten, die op verschillende plekken te lezen zijn, spreken voor zich: het lijkt alsof een mens alles schreef. De zinnen lopen vloeiend en er worden zelfs relevante quotes bedacht. Als een algoritme maar genoeg trainingsdata heeft, kan hij goed imiteren, zo blijkt hieruit.

Bewustzijn kweken over AI

Volgens OpenAI, een soort denktank waar onder andere Elon Musk en Peter Thiel (beiden verdienden miljarden met Paypal) achter zitten, wil mensen bewust maken van de gevaren van ongeremde kunstmatige intelligentie. Het programma is dan ook bedoeld om bewustzijn te kweken. OpenAI denkt dat dit soort techniek makkelijk kan worden gebruikt om grote hoeveelheden realistisch ogend, maar vollstrekt fictief nieuws te creeren.

Nepnieuws kan kwalijke gevolgen hebben bij verkiezingen Zo was er rond de Amerikaanse presidentsverkiezingen van 2016 veel nepnieuws in omloop. Als dat nieuws straks niet eens meer door mensen hoeft te worden geschreven, kan het probleem nog groter worden, zo redeneert OpenAI.

Het is de vraag of de waarschuwing op tijd komt. De kans dat dergelijke programma’s al elders bestaan of binnenkort komen, is groot. ‘Technisch is het niet echt nieuw; vroeg of laat zou een programma als dit verschijnen,’ vertelt Virginia Dignum, die als hoofddocent onderzoek doet naar sociale AI aan de TU Delft. ‘Ik denk dan ook niet dat het te gevaarlijk is om vrij te geven, zoals OpenAI claimt.’

Checks and balances

‘Er zal altijd iemand zijn die AI zoals deze gebruikt voor slechte dingen. Het is aan de maatschappij om genoeg veiligheidsluiken in te bouwen. Zodat deze techniek kan worden herkend, kan worden gecontroleerd en indien nodig onschadelijk kan worden gemaakt. Als je het zo bekijkt, zou het juist beter zijn als OpenAI het algoritme wel vrij zou geven. Dan kan iedereen zien hoe dit soort algoritmen werkt, en nu al maatregelen nemen. Zodat, mocht er in de toekomst een soortgelijk algoritme met kwade bedoelingen zijn, we weten wat de oplossing is.’

Foto: Depositphotos.com