Algemene Rekenkamer: diverse algoritmen overheid ondermaats

Algoritmen die de overheid gebruikt om beleid te ondersteunen, voldoen vaak niet aan de basiseisen voor bijvoorbeeld privacy en objectiviteit. Dat concludeert de Algemene Rekenkamer.

Dit geldt voor zes van de negen algoritmen die de Algemene Rekenkamer onder de loep nam. Een systeem van de politie om agenten zo effectief mogelijk in te zetten, voldoet zelfs aan geen enkele eis.

Algoritmische besluitvorming

De overheid maakt bij het beleid steeds meer gebruik van algoritmen. Denk aan een algoritme dat bekijkt of ingestuurde pasfoto’s voor identiteitsbewijzen wel van voldoende kwaliteit zijn of een algoritme dat het risico op (toeslagen)fraude bepaalt, een risicomodel.

De Algemene Rekenkamer ziet het nut en de noodzaak van de hulp door algoritmen bij het toenemende aantal besluiten dat de overheid moet nemen, maar ziet ook risico’s bij een verkeerde inzet. Daarom heeft het instituut besloten de inzet van algoritmen te toetsen.

Negen algoritmen

Op woensdag 18 mei kwam de Rekenkamer met een rapport over zijn onderzoek naar negen overheidsalgoritmen, die onder andere gekozen zijn op basis van impact op de samenleving, risico op verkeerd gebruik en onderlinge variatie.

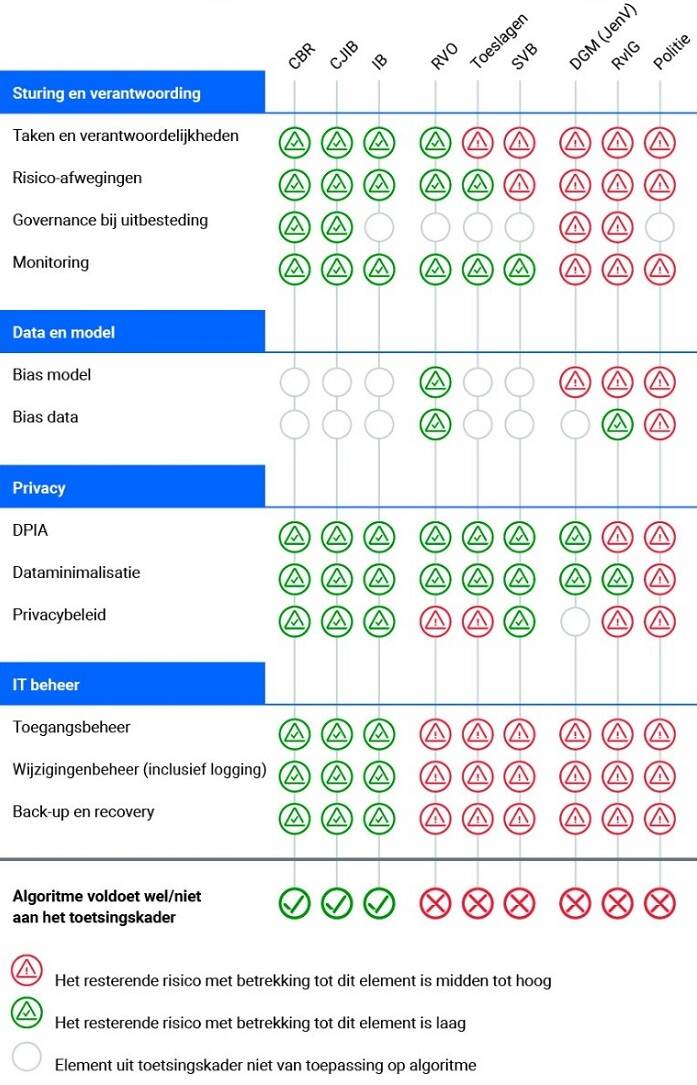

De algoritmen zijn onderworpen aan een toetsingskader dat de Rekenkamer in eerder onderzoek heeft opgesteld. Hierin werd onder andere gelet op de mate waarin de effecten van de algoritmen gemonitord worden, mogelijke vooroordelen (bias), privacy en gegevensbeheer.

Variërend resultaat

Drie van de onderzochte algoritmen worden volgens de Rekenkamer op de juiste manier ingezet. Hieronder vallen een algoritme om kentekens van verkeersovertreders te herkennen en verwerken en een algoritme om mogelijke fraude met bijstandsuitkeringen te signaleren. Zij voldeden aan alle basiseisen.

Andere algoritmen, zoals een slim zoeksysteem dat in persoonsgegevens zoekt of iemand die naar Nederland komt hier al eerder is geregistreerd, voldoen maar aan enkele basiseisen. Een algoritme dat de politie gebruikt om criminaliteit te voorspellen voldoet zelfs aan geen enkele eis.

Criminaliteit voorspellen

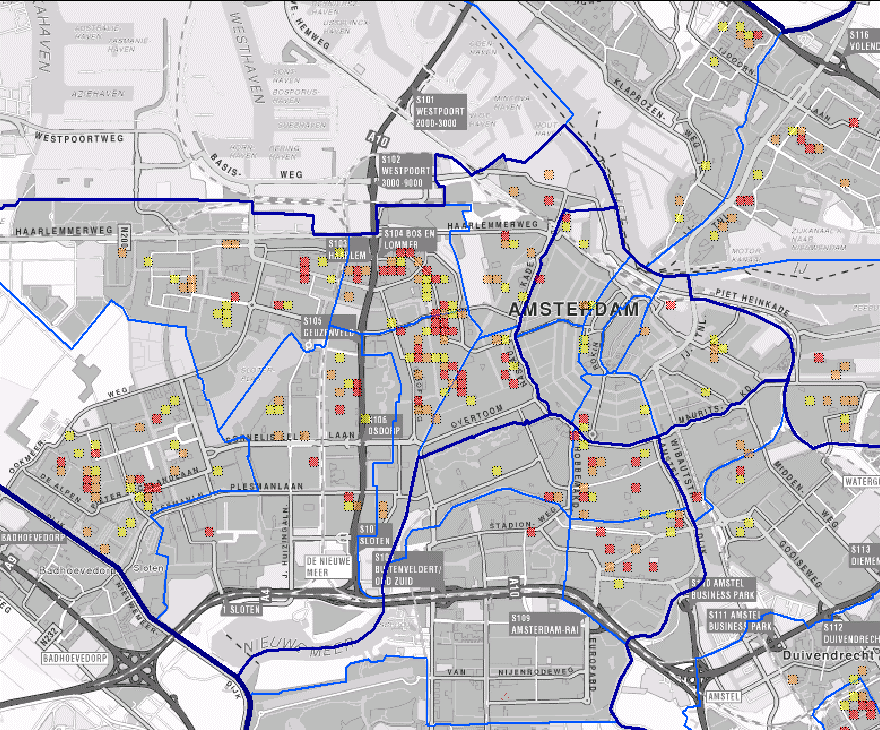

Om agenten optimaal over een stad te verdelen, gebruikt de politie het Criminaliteits Anticipatie Systeem (CAS). Dit is een algoritme dat aan de hand van historische data voorspelt op welke plek en rond welke tijd een hoog risico op misdaad bestaat. (fictief voorbeeld: vannacht rond vier uur is het risico op straatroof nabij het Ingenieurspark groot.) Deze risico-indicaties worden op een kaart getoond.

Een van de risico’s die de Algemene Rekenkamer in het gebruik van het CAS ziet is discriminatie. Hoewel de politie discriminatiegevoelige gegevens als de nationaliteit van de bewoners van een wijk niet als input gebruikt voor het CAS, valt niet uit te sluiten dat het algoritme desondanks discrimineert, zo stelt de Algemene Rekenkamer.

Discriminatie met een omweg

Dat kan als volgt werken: stel dat de politie in het verleden een bepaalde wijk bovengemiddeld intensief monitorde, bijvoorbeeld vanuit racistische vooroordelen. Dan zal in deze wijk meer criminaliteit worden gevonden dan in een wijk met minder blauw op straat, zelfs al zou de criminaliteit op beide plekken gelijk zijn. Wie zoekt zal immers vinden.

Het algoritme ziet dit resultaat en concludeert daaruit dat de intensiever gecontroleerde wijk ook daadwerkelijk een hoger risico op criminaliteit met zich meebrengt. Via een omweg kan een (racistisch) vooroordeel dus alsnog het systeem insluipen, een bekend verschijnsel in de wereld van lerende algoritmen.

Reactie politie

De politie kan zich niet vinden in de kritiek van de Algemene Rekenkamer. Het onderzoek zou verkeerde maatstaven gebruiken, zo laat de politie weten in reactie op het rapport. Het CAS wordt gekeurd als een hoog-risicosysteem, maar zou dat niet zijn omdat de uitkomsten van het algoritme geen individuele burgers treffen. Het systeem opereert immers op wijkniveau.

De Algemene Rekenkamer noemt deze reactie op zijn beurt zorgelijk. Het instituut roept de verantwoordelijke minister op om de politie en ook de dienst Migratie de gevonden risico’s van de algoritmen alsnog aan te pakken, ‘omdat deze wel degelijk burgers kunnen raken.’

Verbetering

In reactie op het gehele rapport heeft Alexandra van Huffelen, staatssecretaris van digitalisering, wel direct actie ondernomen. Ze heeft aangegeven met de betrokken instanties te gaan werken aan een betere inzet van algoritmen.

Openingsbeeld: depositphotos.com