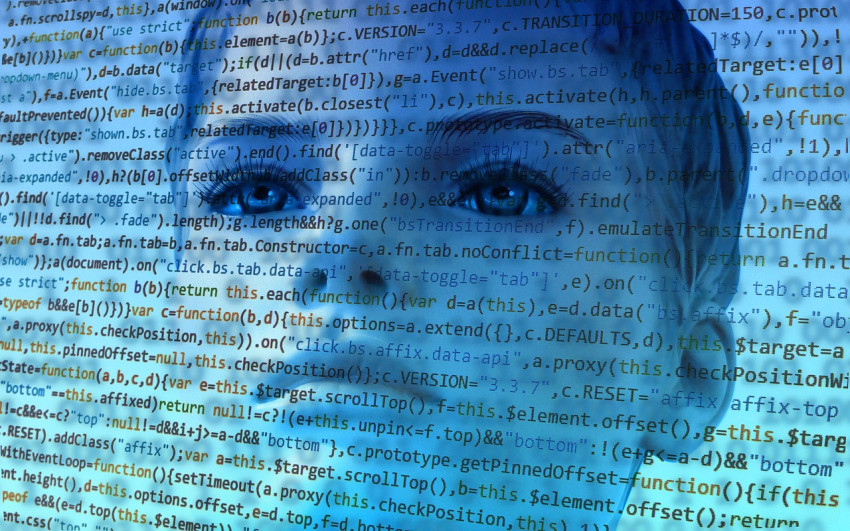

AI heeft vooroordelen, net als de mens

Kunstmatige intelligente valt ten prooi aan dezelfde taalkundige vooringenomenheid als mensen, zo blijkt uit een onderzoek van Princeton University.

De onderzoekers ontdekten dat ogenschijnlijk neutrale termen vaak geassocieerd worden met mannen of vrouwen, en ze ontdekten dat Europees-Amerikaanse namen vaker dan Afro-Amerikaanse namen een positieve associatie oproepen bij een kunstmatige intelligentie. Dat duidt op vooroordelen in een kunstmatige intelligentie, die ze hoogstwaarschijnlijk meekrijgen vanuit het corpus van woorden waarmee de AI wordt getraind.

Associatie

De onderzoekers gebruikten een variant van de zogenoemde Implicit Association Test om de bevooroordeeldheid aan te tonen. Die test gebruiken sociologen regelmatig om associaties bij mensen te testen. Sommige concepten worden snel geassocieerd, als de proefpersoon vindt dat die concepten bij elkaar horen. Vindt de persoon dat ze niet bij elkaar horen, dan is de responstijd veel langer. De test helpt wetenschappers om vooroordelen op te sporen. Soms hebben die vooroordelen een bepaalde lading. Zo worden vrouwen sneller geassocieerd met concepten rond 'het gezin' dan met termen rond carriere. Op eenzelfde wijze worden Europees-Amerikaanse namen eerder geassocieerd met universeel prettige termen (bloemen, muziekinstrumenten) dan Afro-Amerikaanse namen.

De onderzoekers van Princeton hebben nu een test gemaakt voor kunstmatige intelligentie die werkt met taal. Ze pasten hun test toe met een woordencorpus met 2,2 miljoen (engelse) woorden. Als proefpersoon gebruikten de onderzoekers een zelf gebouwde 'AI', die zo simpel mogelijk was. Op die manier konden ze zeker weten dat het gemeten effect zuiver van de leerbron (de 2,2 miljoen woorden) komt, en niet van een ander aspect van het kunstmatige brein.

Niet objectief

Deze simpele AI bleek precies dezelfde 'biases' te hebben als mensen. Dat is tot op zekere hoogte logisch: de AI leert immers met behulp van taal die ook door mensen is geschreven. De onderzoekers merken op dat hun onderzoek laat zien dat taal inherente vooroordelen kan bevatten. Daarnaast beschouwen ze hun artikel in het wetenschappelijk tijdschrift Science als een nadrukkelijke waarschuwing voortoekomstige AI-gebruikers. Nu kunstmatige intelligentie een steeds belangrijker rol krijgt in het maken van beslissingen, moeten gebruikers zich bewust zijn van het feit dat ook een computer vooroordelen heeft, en dat dat dezelfde zijn als die van mensen. Een AI die sollicitatiebrieven beoordeelt is bijvoorbeeld niet objectiever dan een mens, ook al lijkt dat misschien wel zo omdat mensen denken dat computers geen voorkeuren hebben. Dat laatste blijkt dus niet het geval.

Beeld: geralt