Nederland bouwt eigen taalmodel

Nederlandse bedrijven en instellingen gaan GPT-NL bouwen, een eigen taalmodel dat qua technologie te vergelijken is met ChatGPT. Ons land wil voor deze technologie niet afhankelijk zijn van de ondoorzichtige data en algoritmen van Amerikaanse bedrijven.

Dit hebben de drie leidende partijen, TNO, SURF (waarin alle universiteiten en hogescholen hun digitale krachten bundelen) en het Nederlands Forensisch Instituut (NFI), vorige week bekendgemaakt. Voor het ontwikkelen van GPT-NL krijgen zij 13,5 miljoen euro van het Ministerie van Economische Zaken en Klimaat en van de Rijksdienst voor Ondernemend Nederland.

Niet afhankelijk zijn

Veruit de belangrijkste reden om GPT-NL te ontwikkelen en te trainen, is digitale soevereiniteit, vertelt initiatiefnemer Selmar Smit van TNO aan de telefoon. ‘We willen gewoon niet afhankelijk zijn van producten van bedrijven uit de Verenigde Staten.’ Producten die niet transparant zijn.

‘Voor een scholier die met ChatGPT een opstel schrijft, is dit nog niet zo erg, maar voor de Nederlandse overheid en het bedrijfsleven kan het onvoorziene risico’s opleveren dat we niet precies weten wat OpenAI in zijn taalmodellen heeft gestopt en hoe ze zijn getraind.’

Taalmodellen

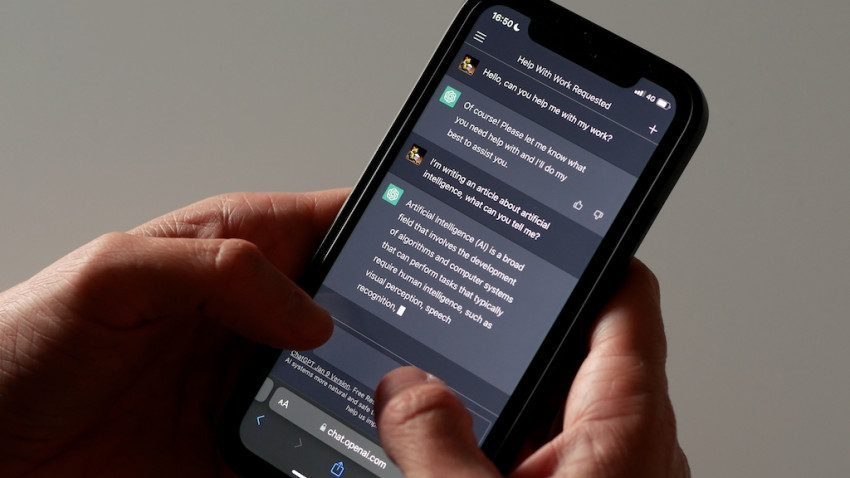

Nog even, wat is een taalmodel ook alweer? Het begrip kreeg pas grote bekendheid onder het brede publiek met de introductie van ChatGPT, in november 2022. Wetenschappers waren al wat langer bezig met taalmodellen. Zo’n taalmodel wordt eerst getraind met heel veel verschillende teksten, waarvan het leert welke lettergrepen met welke statistische waarschijnlijkheid op elkaar volgen. Zo is het taalmodel achter ChatGPT getraind op een flink deel van de webpagina’s van het internet. Stelt iemand vervolgens aan ChatGPT een vraag, dan graaft die in dat enorme geheugen en zet de lettergrepen en de woorden achter elkaar die met de grootst mogelijke waarschijnlijkheid antwoord geven op die vraag. Meer weten? Luister dan naar de eerste aflevering van onze podcast Helder, waarin AI-expert Ilyaz Nasrullah uitlegt hoe ChatGPT precies werkt.

Technologie achter ChatGPT

Vanaf januari gaat het project GPT-NL van start en dan gaan zo’n dertig experts van TNO, SURF en het NFI aan de slag met het bouwen en programmeren van het Nederlandse taalmodel. De bedoeling is niet om het wiel opnieuw uit te vinden, maar deze partijen gaan gebruikmaken van dezelfde technologie als die achter ChatGPT zit. ‘We gaan dezelfde transformers-architectuur gebruiken als in ChatGPT zit. Daarmee hopen we het niveau van GPT-3.5-turbo te bereiken’, zegt Smit.

Trainen met teksten

De eerste stap is vervolgens om dat taalmodel te gaan trainen met geschikte en wenselijke teksten. ‘We gaan het model voeden met zoveel mogelijk platte tekst, die we nu aan het verzamelen zijn bij bedrijven en instellingen die meedoen. Denk aan overheden, uitgeverijen en mediabedrijven.’ Na deze stap kan het getrainde taalmodel al nuttig zijn voor bepaalde eenvoudige toepassingen. ‘Je kan het dan zinnen en teksten laten aanvullen.’

Stap twee is het finetunen van het taalmodel door middel van het geven van instructies. ‘We gaan het model dan voeden met vraag-antwoordparen’, legt Smit uit. ‘Stelt iemand een bepaalde vraag, dan is dít het juiste antwoord, houden we GPT-NL voor.’

Bepaalde antwoorden afleren

Na deze twee fasen kan het taalmodel ook nieuwe vragen beantwoorden waar het niet op is getraind. In fase 3 gaan de bouwers dan bepaalde antwoorden afleren. Bekend voorbeeld van ChatGPT is dat je die niet kan vragen hoe je het beste zelfmoord kunt plegen. Ook zal het ongetwijfeld geen antwoord geven op de vraag hoe je een bom moet bouwen die zoveel mogelijk slachtoffers maakt.

GPT-4

Smit en zijn collega’s willen met GPT-NL niet de concurrentie aangaan met ChatGPT. ‘Dat is niet het doel en dat zal ons ook niet lukken.’ OpenAI is inmiddels bij het kwalitatief veel betere GPT-4 en de Nederlanders willen zoals gezegd het niveau benaderen van een voorganger, GPT 3.5.

Voor de toepassingen van GPT-NL is dat ook niet nodig ‘Het Nederlandse taalmodel dat we trainen moet geschikt zijn om bijvoorbeeld teksten te analyseren, of een brief van de overheid aan burgers te versimpelen, zodat iedereen hem kan begrijpen.’

Iedereen krijgt straks inzage in de data en algoritmen die achter het Nederlandse taalmodel zitten, maar wie er allemaal directe toegang tot het model zal krijgen is nog onderwerp van discussie.

Content leveren

Het daadwerkelijke programmeren en trainen van GPT-NL gaat in januari 2024 van start. Op dit moment voeren de betrokkenen gesprekken met de partijen die de content kunnen gaan leveren, de teksten waarmee het model zal worden getraind. Smit: ‘Wij merken dat zij het belang zien van een eigen, Nederlands taalmodel. Een taalmodel dat anders dan ChatGPT, bestaande teksten zonder te vragen gebruikt. Eigenlijk is dat stelen, ik kan het niet anders noemen.’

Samen optrekken binnen Europa

Binnen Europa is Nederland het derde land dat gaat werken aan een eigen taalmodel. In Duitsland en Zweden zijn ze al bezig, weet Smit. Is het niet slimmer om samen op te trekken? ‘Op een bepaald moment misschien wel, maar wij denken nu dat het slim is dat de landen afzonderlijk ervaring opdoen met het trainen van hun eigen model, en dat we in een latere fase onze opgedane kennis kunnen bundelen. Als je vanaf het begin met alle landen samenwerkt, krijg je een gekunsteld compromis dat helemaal niet werkt.’

Openingsbeeld: het meest bekende voorbeeld van een large language model (LLM) in de praktijk: ChatGPT op een smartphone. Foto Shutterstock