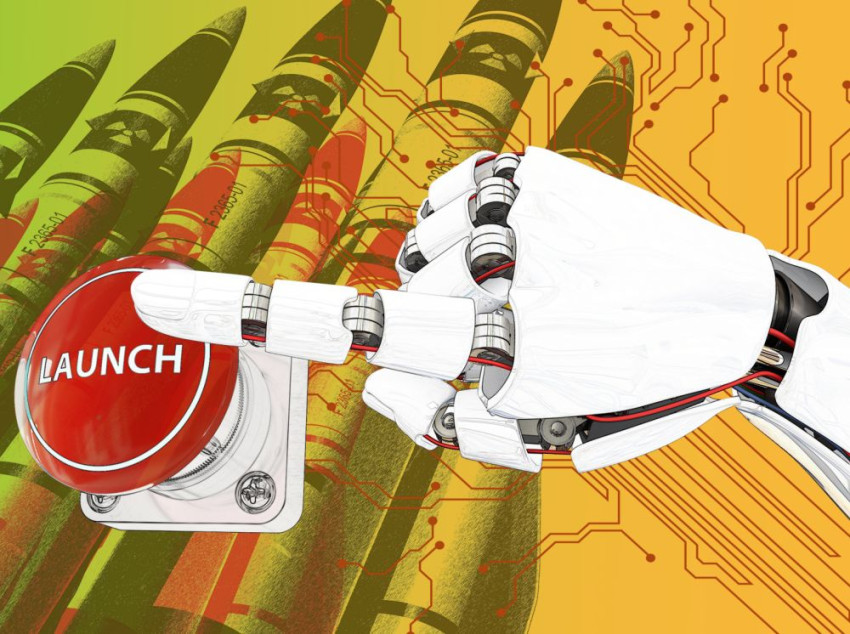

Kunstmatige intelligentie ondermijnt wederzijdse afschrikking

Brengt kunstmatig intelligentie een atoomoorlog dichterbij? Die vraag staat centraal in een publicatie van de Amerikaanse denktank RAND Corporation.

De studie How might artificial intelligence affect the risk of nuclear war? is gebaseerd op verschillende expertmeetings die de denktank organiseerde. Die meetings gingen over de vraag wat kunstmatige intelligentie voor effect kan hebben op het bestaande systeem van nucleaire afschrikking.

Wederzijdse afschrikking

Het strategische concept van wederzijdse afschrikking houdt in dat als de ene partij toeslaat, de andere nog steeds in staat is terug te slaan, zodat beide kampen te maken krijgen met fatale gevolgen. Voor iedere kamp is het dus belangrijk goed in de gaten te houden of de tegenpartij niet bezig is om ergens vandaan een nucleaire raket te lanceren.

Bij die surveillance kan kunstmatige intelligentie een steeds grotere rol gaan spelen. Met gebruik van satellieten, drones, afluistercentra en zelfs sociale media is het mogelijk steeds preciezer te weten wat er gaande is bij vijandelijke lanceerinstallaties. En hoe geavanceerder dat systeem, hoe meer geloof men eraan hecht en hoe groter de rol die het krijgt bij het nemen van een beslissing om al dan niet tot een aanval over te gaan.

Staten zullen dat soort systemen graag willen toepassen, ook als er nog weinig ervaring is met de betrouwbaarheid van die systemen. Zo kunnen data die zijn gebruikt voor het leren van die intelligente systemen onvolkomenheden hebben, net als de gebruikte algoritmen. Daarmee zou het hele systeem een fundamentele fout hebben vanaf het begin.

Is AI wel betrouwbaar?

En daar zien de onderzoekers van RAND het grootste risico. Systemen worden als betrouwbaar beschouwd, ook als ze dat nog niet zijn. Of ze worden gehackt, of krijgen verkeerde inputgegevens. Dat alles zou nog daar aan toe zijn, maar het wordt gevaarlijk als een extra check achterwege blijft, en de uitkomst van het intelligente systeem als voldongen feit wordt geaccepteerd. ‘Autonome systemen hoeven geen mensen te doden om stabiliteit te ondermijnen en de kans op een catastrofale oorlog te vergroten’, aldus Edward Geist, een van de auteurs op de website van RAND. ‘Kunstmatige intelligentie kan er toe leiden dat mensen ervan overtuigd zijn dat ze zich extra kwetsbaar opstellen wanneer ze aarzelen, waardoor ze geneigd zijn sneller op de ‘Rode Knop’ te drukken.' Als het kunstmatige systeem zegt dat er een raketaanval gaande is, dan zal de neiging om dat de geloven sterker zijn. En verder zegt hij: 'Dat de kunstmatige intelligentie alleen adviseert, en mensen uiteindelijk ‘in control’ zijn, biedt dus geen garantie van veiligheid.' We denken dat het AI-systeem het bij het rechte eind heeft, maar dat hoeft niet zo te zijn.

Het gebruik van kunstmatige intelligentie in het militaire domein heeft nog een andere kant, namelijk het intelligent maken van nucleaire wapens. Het rapport noemt als voorbeeld de Russische Status-6, een torpedo-achtige onderwaterdrone die zelfstandig met hoge snelheid zijn weg in zee vindt en in staat is zelf de kernbom aan boord te ontsteken. Ook op die manier heeft gebruik van kunstmatige intelligentie een destabiliserend effect.

Nieuw regime van afspraken

De onderzoekers concluderen dat er met de toepassing van kunstmatige intelligentie in feite een nieuw systeem van wederzijdse afschrikking gaat ontstaan, waarvoor nieuwe afspraken en verdragen nodig zijn. Om te beginnen zou er een internationale dialoog moeten komen over de mogelijke gevaren van het gebruik van intelligente systemen bij het bewaken van militaire activiteiten. Kunstmatige intelligentie zou ingezet kunnen worden om de veiligheid en stabiliteit te vergroten, bijvoorbeeld door verbetering van waarschuwings- en verificatiesystemen. Maar daar moet dan wel, zo benadrukken de RAND-onderzoekers, hard aan worden gewerkt voordat iedere kernmacht met zijn eigen AI-systemen aan de gang gaat en risico’s vergroot.

Vals alarm in 1983

Sinds de vroegste dagen van de Koude Oorlog bestaat de vrees dat computers door een vergissing of kwade opzet de wereld aan de rand van een kernoorlog zouden brengen. Op de website refereert de RAND-denktank aan een voorval in september 1983.

Luitenant-kolonel Stanislav Petrov hield in een geheime bunker in Moskou de nucleaire lanceerinstallaties van de VS in de gaten. Plotseling begint een sirene te loeien en verscheen op de display het woord ‘lancering’.

Petrov wist dat het computersysteem kuren vertoonde. Hij belde de dienstdoende officier op met de mededeling: vals alarm. Maar toen kwam het systeem met verschillende meldingen van ‘lancering’ en een ander scherm toonde in rode letters het woord ‘raketaanval’.

Op zijn schermen zag Petrov dat er vijf raketten op weg waren naar de Sovjet-Unie. Sirenes loeiden. Petrov had in zijn ene hand de officier aan de telefoon, in de andere de technici die radarschermen in de gaten hielden en hem vertelden dat er niks was te zien. Hoezo een oorlog vanuit de VS met maar vijf raketten? Petrov’s herhaalde daarom: vals alarm. En de dienstdoende officier nam dat aan voor waar.

Achteraf bleek dat de wereld aan de rand van een nucleaire oorlog had gestaan, louter omdat het computersysteem de glinstering van wolken aanzag voor een raketlancering.