Autonome auto leert rijden als een mens

Onderzoekers van het Amerikaanse MIT laten een autonome auto navigeren op alleen een eenvoudige kaart en camerabeelden, een beetje zoals menselijke bestuurders dat doen. Dat is een stuk eenvoudiger dan zelfsturende auto’s het tot nu toe doen, en kost dus ook veel minder rekenkracht.

De MIT’ers presenteerden hun bevindingen vorige week op de International Conference on Robotics and Automation in Montreal, Canada. Het werk is van belang omdat het de besturing van toekomstige autonome auto’s een stuk eenvoudiger en energiezuiniger kan maken. Het artikel (pdf-bestand) is nog niet verschenen in een peer-reviewed tijdschrift.

Sensoren

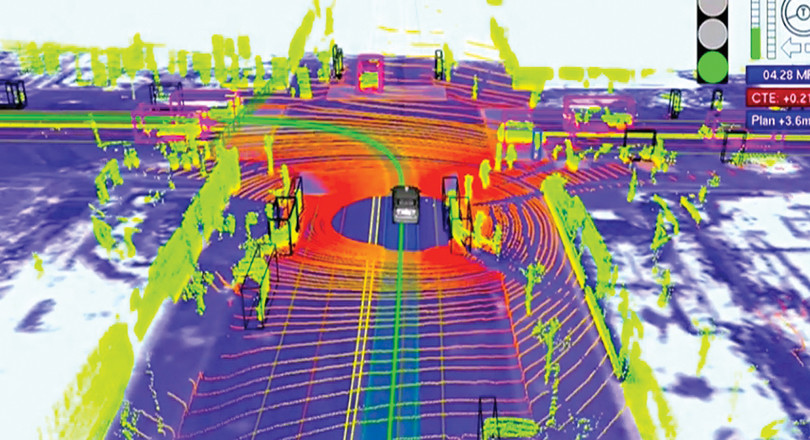

De aanpak die ingenieurs nu meestal gebruiken voor autonome auto’s is als volgt. Zo’n wagen heeft een hele trits sensoren aan boord die de omgeving in kaart brengen. Camera’s om belijning, verkeersborden en overstekende mensen of dieren te herkennen. Radar om grofweg de omgeving in kaart te brengen, en LIDAR om al scannend een precies driedimensionaal model van de omgeving te maken.

De besturing van zo’n autonome auto bestaat dus uit verschillende modules die ieder hun eigen taak hebben. Een voor plaatsbepaling, een voor het detecteren van voorwerpen, een voor besturen van de auto, enzovoort. Die sensoren en modules zijn continu aan het meten en rekenen, dus je kunt je voorstellen hoeveel computercapaciteit - en dus stroom - dit vergt.

Stuurcommando's

De onderzoeksgroep van hoogleraar Daniela Rus aan het MIT pakt dit anders aan. Zij werkt aan zogeheten end-to-end-navigatiesystemen, die op basis van (visuele) input de juiste stuurcommando’s berekenen. Tot nu toe was het werk van de groep beperkt gebleven tot het veilig volgen van de weg, maar met dit nieuwe werk kan de autonome auto ook naar een vooraf ingevoerde bestemming rijden.

Centraal bij deze nieuwe vorm van besturing staat een neuraal netwerk (om precies te zijn een convolutional neural network (CNN), het type dat goed is in het herkennen van plaatjes) dat in de besturing van de auto zit. Dat ‘leert eerst het vak’ van een menselijke bestuurder. In de trainingsfase zit er dus een mens achter het stuur (van een Toyota Prius in dit geval) die een heleboel verschillende routes rijdt.

Voldoende trainen

Het gaat erom dat het neurale netwerk allerlei situaties vastlegt, en hoe de menselijke bestuurder daarop reageert. Is er een haakse bocht, dan beweegt het stuur op die manier. Een T-splitsing? Daar slaat de bestuurder links- of rechtsaf. Als er maar voldoende T-splitsingen worden getraind, dan ontdekt het neurale netwerk op den duur dat je daar niet rechtdoor kunt rijden.

Volgens de MIT’ers is het grote voordeel van hun systeem dat je een op deze manier getrainde autonome auto gemakkelijk een nieuwe route kunt laten rijden. ‘Met ons systeem hoef je niet van tevoren op elke nieuwe weg te trainen’, zegt eerste auteur Alexander Amini, promovendus aan MIT in een nieuwsbericht. ‘Je kunt simpelweg een nieuwe kaart downloaden om over wegen te navigeren die de wagen nog nooit eerder heeft gezien.’ Net als een mens dat zou doen dus.

Van stedelijke omgeving naar het bos

‘Ons doel is om autonome auto’s gemakkelijk te laten rijden in nieuwe omgevingen’, zegt medeauteur Rus in het nieuwsbericht. ‘Als we bijvoorbeeld een autonoom voertuig trainen om in een stedelijke omgeving te rijden, moet het systeem ook soepel in een bos kunnen rijden, zelfs als de auto die omgeving nog nooit eerder heeft gezien.’

Een bijkomend voordeel van de nieuwe methode is dat er niet voortdurend een 3D-model van de omgeving hoeft te worden gecreëerd. De autonome auto zou kunnen volstaan met een paar goede breedbeeld-camera’s die de omgeving filmen, en een computer die aan de hand van het wegbeeld. En natuurlijk een gps-systeem aan boord, dat een wegenkaart bevat en waarop de bestemming is ingevoerd.

Openingsfoto Pixabay